Группа исследователей искусственного интеллекта из Google и Берлинского технического университета представила PaLM-E — мультимодальную визуальную языковую модель с 562 млрд. параметров, которая объединяет компьютерное зрение и язык для управления роботами. Учёные утверждают, что это самая большая мультимодальная модель из когда-либо созданных и что она может выполнять множество задач без необходимости переобучения. С подробным описанием модели можно ознакомиться по ссылке.

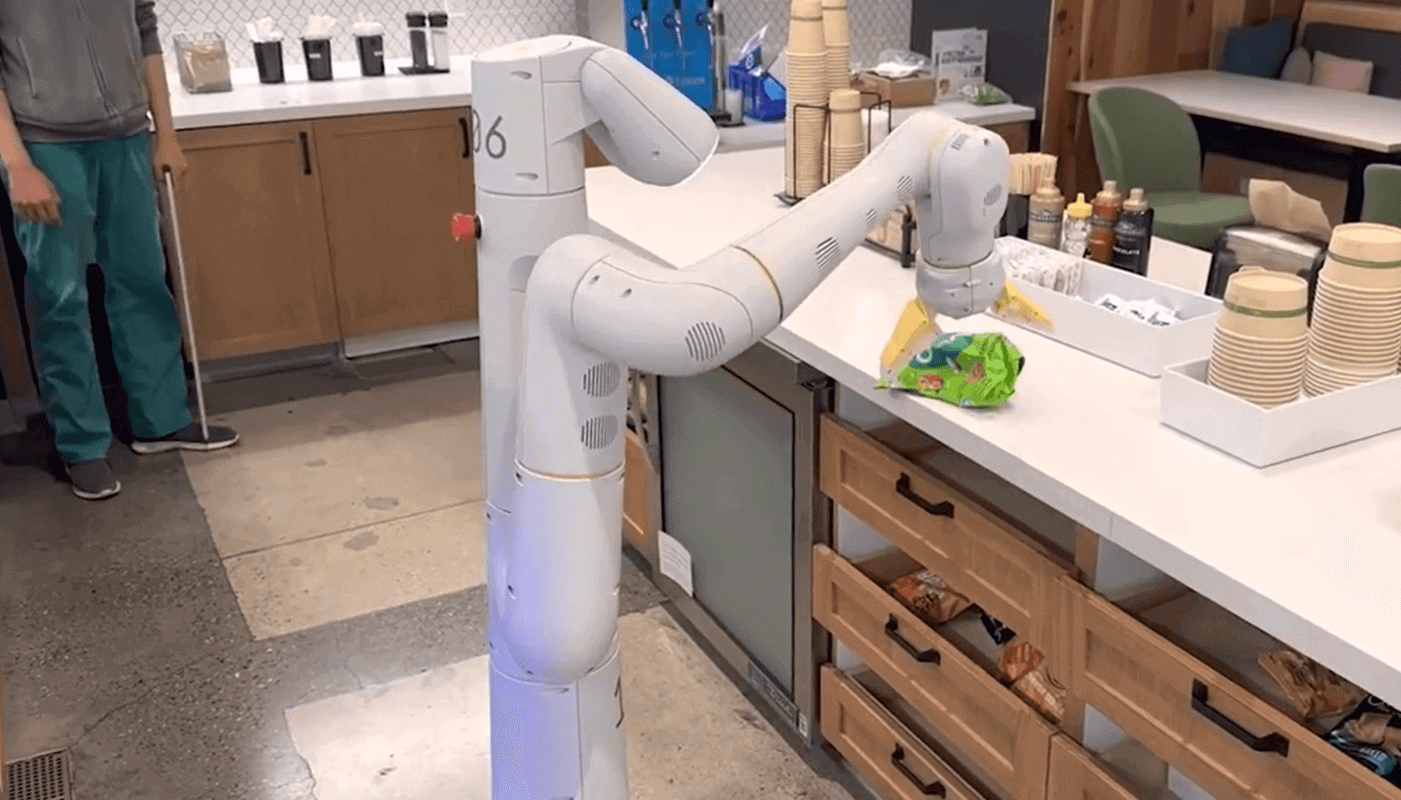

При получении сложной команды, состоящей из нескольких объектов (например, «принеси мне чипсы из ящика»), PaLM-E генерирует план действий для мобильной роботизированной платформы с рукой и выполняет действия самостоятельно. PaLM-E работает , анализируя данные с камеры робота, не требуя предварительно обработанного представления сцены. Это устраняет необходимость в аннотировании данных человеком и обеспечивает автономное управление роботом.

Стоит отметить, что, если PaLM-E интегрирована в контур управления, она становится устойчивым к прерываниям, которые могут возникнуть во время выполнения задачи. В исследовательской работе Google объясняется, как PaLM-E превращает инструкции в действия. Роботу дают установку о необходимости планировать последовательность навигационных и манипулятивных действий на основе инструкций человека. Например, учитывая инструкцию «Я пролил свой напиток, принеси мне что-нибудь, чтобы убрать здесь», робот должен спланировать последовательность действий:

- Найти губку.

- Поднять губку.

- Принести губку пользователю.

- Положить губку.

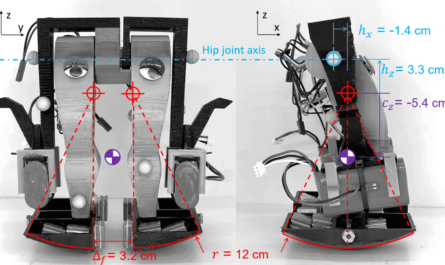

Эксперты разработали 3 варианта для проверки способностей PaLM-E к рассуждению: прогноз доступности, обнаружение сбоев и долгосрочное планирование. Модель основана на существующей большой языковой модели Google Pathways Language Model (PaLM). Она похожа на технологию, лежащую в основе ChatGPT, только в неё добавлена сенсорная информация и роботизированное управление.

PaLM-E также опирается на модель распознавания образов Google ViT-22B , которая может классифицировать изображения, обнаруживать объекты, проводить семантическую сегментацию и создавать подписи к изображениям. Более того, PaLM-E может передавать полученные знания и навыки, что значительно увеличивает производительность по сравнению с однозадачными моделями. Исследователи утверждают , что PaLM-E демонстрирует совершенно новые возможности, такие как:

- мультимодальная логическая цепочка рассуждений (модель анализирует последовательность входных данных, включающих как языковую, так и визуальную информацию);

- мультиобразный вывод (использование нескольких изображений в качестве входных данных, чтобы сделать вывод или прогноз).