Все вокруг обсуждают большие данные, но многие плохо представляют себе о чём идёт речь. Это подробный и доходчивый материал о том, что же такое big data, и почему про это все говорят.

До нас до сих пор доходят волны информационного взрыва начала нулевых. Объём данных в мире растёт с каждым годом. Чтобы не потонуть в потоке шумов, миру понадобились технологии обработки больших объёмов информации и новые программные инструменты. Так возникла data science и рынок больших данных.

Компания International Data Corporation посчитала, что в 2003 году на цифровых носителях было 5 эксабайтов данных (1 Эб = 1 млрд Гб). В 2020 мировой объём данных увеличился до 59 зетабайт (1 ЗБ = 1024 эксабайта).

Что такое большие данные?

Термин большие данные совсем новый, но в его определении уже много путаницы. Впервые его употребил редактор журнала Nature Клифорд Линч в 2008 году, и с того времени термин быстро набирал популярность. Несмотря на то, что к этому приковано много внимания, не всегда ясно, что именно имеется в виду под большими данными.

Согласно первому определению, большие данные — это структурированная и неструктурированная информация больших объёмов. Очень больших. Чтобы данные считались большими, поток информации должен быть выше 100 Гб в день.

В профессиональной среде под термином «большие данные» понимают всю совокупность технологий для работы с большими объёмами информации. Этим занимается data science — наука, использующая методы статистического анализа данных, дата майнинга и машинного обучения.

Как развивались технологии хранения данных

Сбор данных начался с зарождением культуры и письменности — около 8 тыс. лет назад. Поначалу хранение данных было очень дорогим, поэтому им занималось только государство и религия. Древнейшими данными были списки налогоплательщиков, умерших, перепись населения.

В конце XIX века американское бюро по переписи населения столкнулось с проблемой: на обработку собранных данных у них должно было уйти 10 лет. К тому моменту эти данные бы очень устарели, и пора было бы собирать новые. На помощь им пришёл учёный и изобретатель Герман Холлерит.

Холлерит создал электрическую табулирующую систему. Она была устроена таким образом: специальные машины считывали данные с бумажных перфокарт . Информация содержалась в наличии или отсутствии отверстий на картах, и с помощью электромагнитных импульсов приводили в движение счётчики. Это был по-настоящему революционный механизм. Он помог сократить время на обработку данных по переписи населения до трёх месяцев.

Табуляторы стали первой технологией хранения данных, а компания по их производству стала позднее называться IBM. Первые базы данных хранились в виде таких перфокарт. Табулирующую систему стали использовать не только для переписи, но и в бухгалтерии, учёте, при научно-технических и военных расчётах.

В 50-е года возник новый метод хранения данных. Компания American Airlines создала систему SABRE. Это была первая система бронирования в режиме реального времени. Информация о местах и проданных билетах хранилась теперь исключительно на компьютерах и это позволило сильно сократить время на оформления билетов. American Airlines стала первым заказчиком компьютеров для обработки больших объёмов информации. Техническим обеспечением системы бронирования занималась компания IBM.

Хранение и обработка больших данных в то время стоили очень дорого. Когда SABRE только появилась, её цена была настолько высока, что её могла позволить себе только авиакомпания. Но с каждым годом стоимость микросхем для компьютеров снижалась, а их производительность увеличивалась. Начал работать так называемый Закон Мура. Благодаря этому явлению, вычислительную технику стали применять во всё более дешёвых отраслях.

За десять лет цена падала в десятки раз: то что в 1955 году стоило 10$ к 1965 стало стоить несколько центов, а к 1975 только доли цента.

В 1977 году Ларри Эллисон создал новую систему управления базами данных под названием Oracle System. Эллисон впоследствии стал одним из самых богатых людей на планете, а Oracle крупнейшим производителем ПО и серверного оборудования. Идея, которая легла в основу новой технологии, принадлежала Теду Кодду из IBM. Её суть состояла в следующем. Раньше данные хранились в виде таблиц в памяти компьютера или на магнитной ленте. Это была плоская файловая база данных. Чтобы внести в неё изменения, приходилось полностью её переписывать и создавать новую базу. В новой реляционной модели базы данных стало возможно управлять данными, удалять их, добавлять и даже запрашивать данные. Кроме того, Oracle создала возможность запускать своё программное обеспечение на разных типах компьютеров, обеспечив гибкость использования.

С 1987 года компании начали использовать интернет. Точкой доступа к нему стал персональный компьютер, а сервером, где физически хранились все данные был более крупный компьютер с реляционной базой данных вроде Oracle.

Закон Мура продолжал работать. Из-за снижения цены на микропроцессоры стало возможным развитие персонального компьютера. А падение цен на сервера в середине 90-х привело к развитию интернета. К 2005 году стоимость вычислений снизилась ещё в два раза и это стало новой вехой в развитии компьютера. С этого момента начали развиваться мобильные компьютеры и облачные хранилища.

Что такое майнинг данных?

Когда компьютеры увеличили мощности, их стали использовать для хранения баз данных, хотя они были созданы прежде всего для вычислений. Не вся информация, хранящаяся в базах данных, одинаково полезна. Появился запрос на такие технологии, которые позволяют быстро находить и обрабатывать информацию.

Так в середине 90-х появился майнинг данных — способ добычи данных и значимых закономерностей в них. Под дата майнингом понимается и поиск, разработка и анализ полезной информации. Для извлечения полезной информации из базы данных был разработан специальный язык запросов — SQL.

Сейчас майнинг — это часть data science, одного из самых актуальных направлений в IT. По расчётам IBM, до сих пор в мире около 80% необработанных данных, которые хранятся в основном в виде текста.

Майнинг данных применяется в анализе соцсетей, финансовой области, медицине, менеджменте, производственном процессе. Для рабаты с базами данных нужны квалифицированные специалисты, а их не хватает. Большие данные — это не средство, а только ресурс в руках аналитиков.

Большие данные и искусственный интеллект

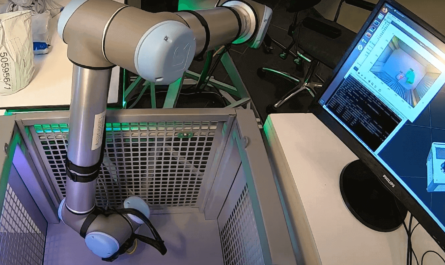

Машинное обучение и искусственный интеллект — это ещё одна составляющая data science. Развитие искусственного интеллекта произошло благодаря большим данным, которые стали для него топливом.

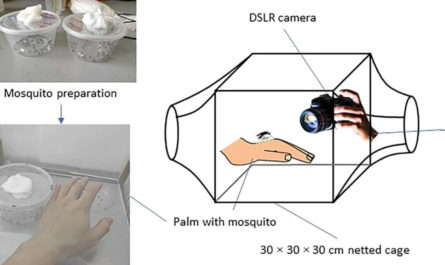

Машинное обучение — это метод работы ИИ. Это обучение через решение множества подобных задач и выработке алгоритма. При обучении программа использует базы данных, и чем более они обширны, тем более развитым будет ИИ.

Что сделал Google

Как найти что-то в интернете? В 1998 году в сети 30 миллионов сайтов, сейчас уже больше двух миллиардов. На сайтах могут быть тысячи страниц с огромными объёмами информации. Для её прочтения были созданы специальные поисковые роботы spiders. Они индексируют все существующие в интернете страницы и их содержимое — метаданные.

Для поиска и ранжирования страниц Google стал использовать алгоритм PageRank. Этот алгоритм выстраивал найденные страницы в порядке «интересности», который определялся количеством ссылок на ту или иную страницу. То есть, чем больше людей упоминали эту страницу, тем более полезной она оказывалась.

Поисковики стали первым применением больших данных в интернете. Для того чтобы связать поиск с рекламой нужно было ещё сильнее снизить стоимость обработки данных.

Google создал такие технологии, благодаря которым множество ПК стали работать как единый суперкомпьютер. С помощью своих изобретений они сделали возможной совместную работу тысячи компьютеров над одной задачей. Это стало настоящим прорывом.

Для того чтобы увеличить прибыль от рекламы гуглу понадобился новый инструмент. Он начал предлагать нам рекламу, по которой мы перейдём с вероятностью в 10 раз выше.

MapReduce — это модель распределения big data. Эта технология используется для параллельного вычисления данных объёмом от петабайта. MapReduce — главная гугловская технология больших данных. Именно благодаря этой технологии большие данные стали индустрией.

В Кремниевой долине давно поняли, что необходимо регистрировать каждый шаг пользователей: что мы смотрим и читаем, какие места посещаем, какие у нас интересы и какие есть проблемы в поведении у вашей собаки. Эта информация никуда не исчезает. Сбор этих данных используется прежде всего в рекламе. Они помогают маркетологам подтолкнуть нас к покупке определённых товаров.

Джефф Безос построил свою компанию Amazon на основе интернета и больших данных. Он хотел избавить людей от посредников в виде магазинов. Его идея была полностью основана на реляционной системе базы данных Oracle. Система записывала каждый шаг клиента: историю заказов, просмотров, а со временем буквально каждый клик на сайте. История недавних действий радикально изменила интернет-бизнес и стала возможна благодаря Большим данным. Именно поэтому Amazon сейчас оценивается в $347 млрд.

Где используются большие данные?

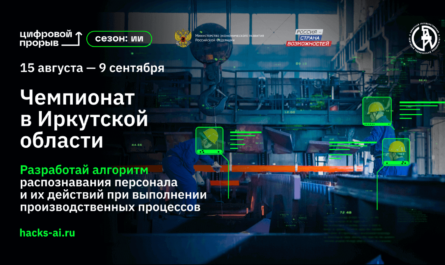

Сегодня большие данные стали частью многих отраслей бизнеса. Бизнес-аналитика — это одно из главных применений больших данных сегодня. Согласно статистике IBM, большие данные используют в основном в сфере клиентского сервиса и маркетинга, а также в телекоммуникациях, промышленности, логистике, здравоохранении.

Через собранные данные бизнес узнаёт о предпочтениях клиентов и предлагает наиболее релевантные товары, а так же измеряет, насколько эффективна та или иная маркетинговая кампания. Исходя из анализа больших данных компании делают выводы об эффективности работы, занимаются прогнозами и планированием.

Реклама и медиа. Одна из самых популярных областей применения больших данных — контекстная реклама. Роботы отслеживают каждый наш шаг в интернете и продают рекламу наиболее эффективно.

Google и Facebook сегодня контролируют 85% рекламного рынка благодаря своим сервисам аналитики big data. В борьбе с ними начали объединяться крупнейшие медиа ресурсы — Guardian, CNN, Financial Times, The Economist. Их примеру последовали и немецкие издатели. Они собирают общую базу данных, стремясь отвоевать у доминирующих компаний долю на рынке цифровой рекламы, поскольку любое медиа нуждается в больших данных.

Ритейл. Базы данных розничных магазинов могут хранить информацию о клиентах, поставках, продажах. С помощью анализа этих данных компании отслеживают колебания спроса, оптимизируют поставки, составляют отчётность. В общем, большие данные полезны во всех сферах деятельности магазинов.

К примеру, компания Target с помощью анализа больших данных увеличила прибыль на 15-30%. Она научилась вычислять будущих матерей и предлагала им товары, которые с высокой вероятностью купят беременные женщины.

Human Resources. При помощи больших данных можно отбирать наиболее подходящих кандидатов или прогнозировать вероятности ухода сотрудников в другие компании.

Медицина. Область применения больших объёмов данных в медицине очень широка. Специалисты используют их для диагностики, прогнозируют вспышки заболеваний, отслеживают эффективность лекарств. К примеру, анализ больших данных помогает во время пандемии коронавируса.

Безопасность. Компании используют анализ больших данных для того чтобы спрогнозировать сбои и аварии. Это применяется везде — от энергетики до спутниковых систем.

Финансы. Банки используют прогнозирование на основе big data для того чтобы оценить платёжеспособность заёмщиков на основе статистических методов. В биржевой торговле уже давно применяются торговые роботы, которые анализируют рынок и действуют как трейдеры.

Мобильная связь. У мобильных операторов база данных одна из самых больших. С её помощью они делают всё, для того чтобы найти новых клиентов и удержать существующих. Компании мобильной связи анализируют трафик, отслеживают поведение абонентов и проверяют их платёжеспособность. Например, телекоммуникационная компания из Норвегии снизила отток клиентов на 36% с помощью анализа больших данных.

Анализ больших данных делает возможными немыслимые ранее вещи. Это меняет все сферы нашей жизни: государственное управление, медицину, науку, рекламу. Наука о данных и машинное обучение будут развиваться, а рынок технологий big data продолжать расти.

Статья написана в партнёрстве со Skillbox.